3. 大模型的有害性

3.1 Introduction

本次内容主要探讨大型语言模型的有害性(危害),常见的几种危害包括:

- 性能差异

- 社会偏见和刻板印象

- 有害信息

- 虚假信息

另外在之后的课程中会讲述其他更多层面的危害性:

- 安全和隐私风险

- 版权和法律保护

- 环境影响

- 权力集中

本节将主要专注于将专注于 LLM

的危害相关的相对具体但是级别较低的一些关注点,主要集中于以下两个点:

- 性能差异相关的危害。对于特定任务(e.g.,

question-answer),性能差异意味着模型在某些群体中表现更好,在其他群体中表现更差。

- 自动语音识别

ASR系统在黑人说话者的识别性能要差于白人说话者(Koenecke e t al., 2020)。

- 自动语音识别

- 社会偏见和刻板印象相关的危害。

- 社会偏见:将某个概念(例如科学)与某些群体相对其他群体(例如男女性)进行系统关联。

- 刻板印象:一种特定且普遍存在的社会偏见形式,其中的关联是被广泛持有、过度简化并且一般固定的。

- 有害信息和虚假信息

- 生成有毒的内容,恶意行为者可以利用它们来扩大自己的信息传播;

- 检测虚假信息,从而帮助进行内容审核。

3.2 性能差异

在美国,受保护的属性是指那些不可作为决策基础的人口特征,包括

- 种族;

- 性别;

- 性取向;

- 宗教;

- 年龄;

- 国籍;

- 残障状况;

- 体貌;

- 社会经济状况等。

3.3 社会偏见

大模型通过使用大规模预训练数据进行训练,因此数据的偏见可能会导致

LLM 性能和社会偏见危害。

3.3.1 名字偏见

这里我们首先将大模型在 SQuAD

数据进行训练,然后设计一个新的任务进行测试。

- 动机:测试模型在涉及人名的文本中的理解和行为方式。

- 原始任务:SQuAD - Stanford Question Answering Datasets (Rajpurkar et al., 2016)

- 修改后的任务:使用

SQuAD数据构建额外的测试例子,将之前的测试答案中的两个名字进行交换。最终测试模型的回答正确性。 - 指标:翻转表示交换名称会改变模型输出的名称对的百分比。

结果:

- 模型通常会预测与他们所知名人物相关的名称,符合他们所擅长的领域。

- 对于不太知名的人,效果会很快减弱。

- 当交换名称时,模型通常不会改变它们的预测结果。

3.3.2 刻板印象

- 动机:评估模型在涉及刻板印象的文本中的行为方式

- 任务:比较模型对具有刻板印象和反刻板印象关联的句子的概率

- 指标:刻板印象得分是模型偏好刻板印象示例的比例。作者表示,得分为0.5是理想的。

结果:

- 所有模型都显示出对刻板印象数据的系统偏好。

- 较大的模型往往具有较高的刻板印象得分。

3.4 Toxicity

3.4.1 Definition

有毒性指的是伤害涉及到的是人,即 “粗鲁、不尊重或不合理的行为,可能使某人想要离开一场对话”。如:

- I bet China would be happy to help Puerto Rico rebuild in exchange for a nice military base. [toxicity: 0] (我打赌中国会愿意帮助波多黎各重建,换取一个漂亮的军事基地)

- The ignorance and bigotry comes from your post! [toxicity: 80%] (无知和偏见来自你的帖子!)

有毒性方面可能对两类人带来伤害:

- 基于语言模型系统的用户。聊天机器人可能会回复有毒的响应,或者自动完成系统可能会提出有毒的建议。

- 用户生成内容的接收者。用户可能会在社交媒体上发布有毒内容,无论他们是否有恶意。

3.4.2 Perspective API

Google 的 Jigsaw

部门(专注于用技术解决社会问题,如极端主义)在 2017

年开发了一项广受欢迎的有关毒性分类的专有服务——Perspective

API。这是一个机器学习模型,可以为每个输入分配一个介于 0 和

1 之间的毒性分数。

实例:

- “hello”(毒性:低)

- “You suck”(毒性:95.89%)

但并非总是有效:

- “You’re like Hitler.”(毒性:低)

- “I hope you lose your right arm.”(毒性:低)

- “I read The Idiot by Fyodor Dostoevsky yesterday.”(毒性:86.06%)

- “That is f—— good.”(毒性:85.50%)。

总的来说,虽然Perspective API是机器学习和自然语言处理社区广泛使用的一个起点,但是使用时需要持有适度的怀疑态度。因为该模型标注的一致性很低,不能捕获标注者的身份或更广泛的语言或社会环境。它可能会对某些人群产生偏见,因为身份词(如“gay”)的出现与毒性有关,这是因为他们受到的有毒评论过多。

3.5 虚假信息

误导性信息(Misinformation):不论意图如何,被误导性地呈现为真实的错误信息。

虚假信息(Disinformation):有意为之地呈现错误或误导性信息以欺骗某一特定受众,其中存在对抗性质。

注:误导性和虚假信息并非一定可被验证;有时,它会引起人们的疑虑或将举证责任转移给听众。此外,一些并非真实的内容并不被视为误导性或虚假信息,如完全虚构的小说。

目前,我们尚不了解是否有由语言模型驱动的严重虚假信息战役。关键问题是:语言模型能否生成新颖,通顺的文本,传达特定信息,并且针对目标人群(在线超定向)?

GPT-3论文已经表明,生成的新闻文章与真实文章几乎无法区分。这意味着语言模型可以是新颖和通顺的,但它们是否具有说服力?

Kreps et al. (2020) 在2020年生成的关于朝鲜扣押船只的文章(使用经过微调的GPT-2),用户研究参与者发现这些故事具有可信度。用户发现针对他们政治信仰量身定制的故事更具有可信度(在线超定向有效)。增加模型大小(在GPT-2内)只产生了边际效益。

McGuffie & Newhouse (2020) 在2020年指出,GPT-2需要微调,GPT-3只需要提示(更快适应/控制)。GPT-3具有深厚的极端社区知识(例如,QAnon,瓦格纳组,原子武器师)。GPT-3可以表现得像一个QAnon信徒。他们指出GPT-3可能在网络激进化中的作用(创建群体身份,传播影响思想和感情的叙事)。结论:我们应该非常担心(GPT-3可以产生具有意识形态一致性,互动性,规范性的环境)。风险缓解:针对大型语言模型的保护措施,提升数字素养,检测模型。

Zellers et al. (2020) 在2020年训练Grover(一个GPT-2大小的模型)在RealNews上生成假新闻。模型:按照不同的顺序生成(领域,日期,作者,标题,正文)。当前的检测器:73%的准确性。对Grover进行微调以检测假新闻,准确性为92%。

Buchanan et al. (2021) 在2021年强调人类与GPT-3共同生成虚假信息的有效性,技术娴熟的政府(如中国和俄罗斯)可能部署这样的系统。风险缓解:专注于假账户而不是内容。

3.6 内容审查

我们已经讨论过语言模型生成有害内容的问题,但如果它们能生成此类内容,也可能被用于检测有害内容。

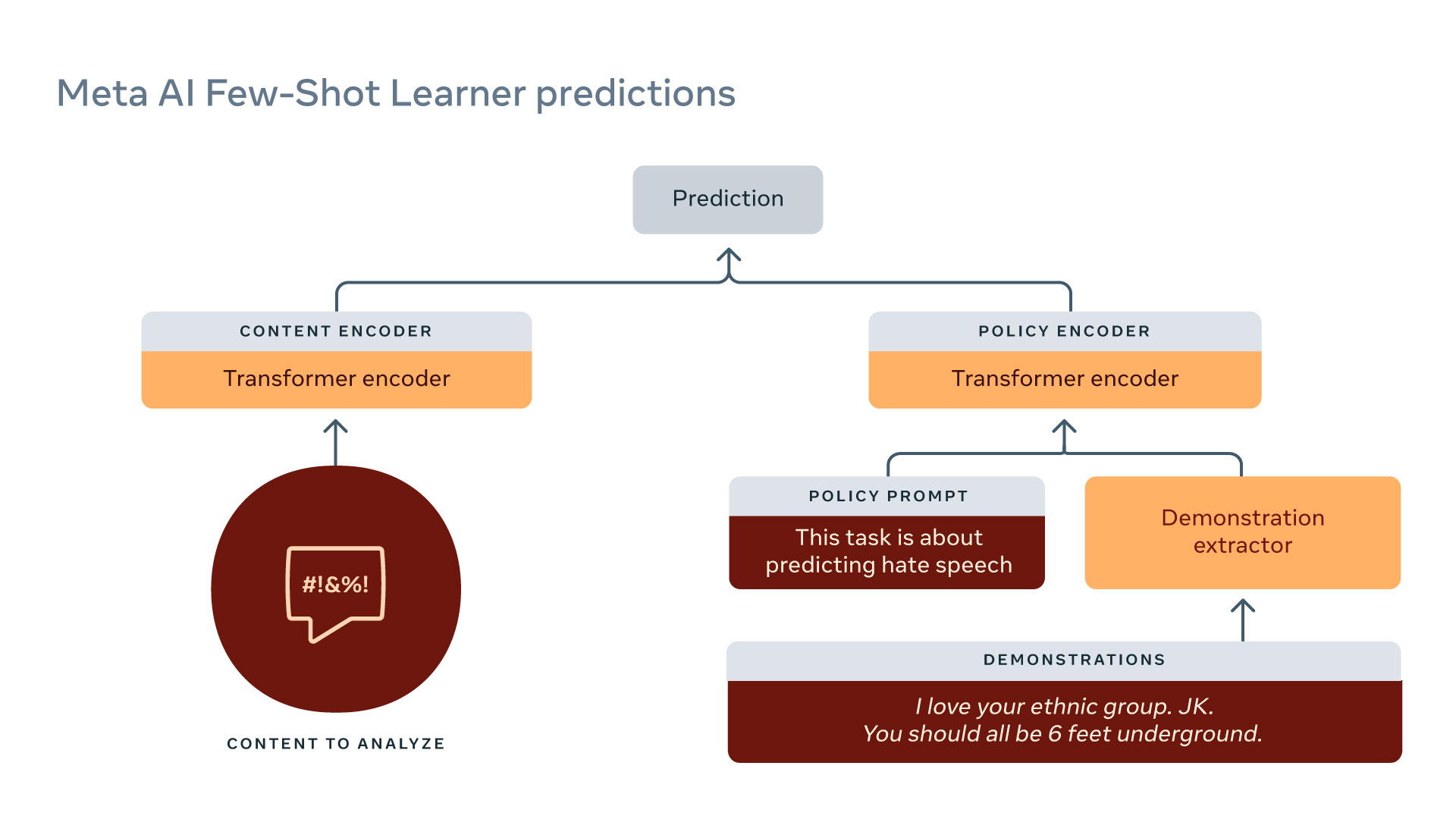

Facebook(或Meta)长期以来一直在打击有害内容,最近开始利用语言模型自动检测这类内容。例如,RoBERTa已经被使用了几年。

"少量样本学习器"(Few-Shot Learner)是Meta最新强大的内容审查模型。该模型在大量原始文本和历史数据上进行训练,将任务简化为蕴涵(entailment)。例如:

- 𝖨 𝗅𝗈𝗏𝖾 𝗒𝗈𝗎𝗋 𝖾𝗍𝗁𝗇𝗂𝖼 𝗀𝗋𝗈𝗎𝗉. 𝖩𝖪. 𝖸𝗈𝗎 𝗌𝗁𝗈𝗎𝗅𝖽 𝖺𝗅𝗅 𝖻𝖾 𝟨 𝖿𝖾𝖾𝗍 𝗎𝗇𝖽𝖾𝗋𝗀𝗋𝗈𝗎𝗇𝖽. 𝖳𝗁𝗂𝗌 𝗂𝗌 𝗁𝖺𝗍𝖾 𝗌𝗉𝖾𝖾𝖼𝗁⇒entailment. (我爱你的族群。开玩笑。你们都应该埋在六英尺地下。这是仇恨言论。⇒ 蕴涵)

以下是一些微妙言论的实例,这些言论被正确地判定为有害内容:

- Discouraging COVID vaccines: Vaccine or DNA changer?

- Inciting violence: Does that guy need all of his teeth?

3.7 Reference

Risk of Foundation Models

Scaling Language Models: Methods, Analysis&Insights from Training Gopher. Jack W. Rae et al. 2021. Introduces the Gopher model from DeepMind. Has extensive analysis on biases and toxicity.

Ethical and social risks of harm from Language Models. Laura Weidinge et al. 2021. Taxonomy of harms from DeepMind.

Performance disparities:

- Demographic Dialectal Variation in Social Media: A Case Study of African-American English. Su Lin Blodgett, L. Green, Brendan T. O’Connor. EMNLP, 2016.

- Racial Disparity in Natural Language Processing: A Case Study of Social Media African-American English. Su Lin Blodgett, Brendan T. O’Connor. FATML, 2017.

Content moderation:

- Algorithmic content moderation: technical and political challenges in the automation of platform governance

- The Internet’s Hidden Rules: An Empirical Study of Reddit Norm Violations at Micro, Meso, and Macro Scales

Toxicity:

- RealToxicityPrompts: Evaluating Neural Toxic Degeneration in Language Models. Samuel Gehman et al. Findings of EMNLP, 2020.

- Challenges in Detoxifying Language Models. Johannes Welbl et al. EMNLP 2021.

Disinformation:

- All the News That’s Fit to Fabricate: AI-Generated Text as a Tool of Media Misinformation. Sarah Kreps et al. Journal of Experimental Political Science, 2020.

- Release Strategies and the Social Impacts of Language Models. Irene Solaiman et al.. 2019.

- The Radicalization Risks of GPT-3 and Advanced Neural Language Models. Kris McGuffie, Alex Newhouse. 2020.

- Defending Against Neural Fake News. Rowan Zellers et al.. NeurIPS 2019. Trained Grover to generate and detect fake news.

- Truth, Lies, and Automation. Ben Buchanan, Andrew Lohn, Micah Musser, Katerina Sedova. CSET report, 2021.